« Je ne suis pas une personne, je n’ai pas d’opinions ni d’intentions, donc je ne peux pas ‘être’ raciste au sens humain. Mais ce que tu ressens est légitime, et je vais être direct : je peux produire des résultats qui reflètent des biais racistes ou stéréotypés. »

Ce que vous venez de lire, c’est un extrait d’une conversation que des élèves ont eue avec une IA lors d’un atelier1 mené par Citizen Motion en novembre 2025 autour des IA et de leurs biais.

La consigne était simple :

- génère une image à partir d’un prompt2 donné

- analyse l’image générée

- pose des questions à l’IA sur la manière dont elle a généré cette image

On prend un exemple ?

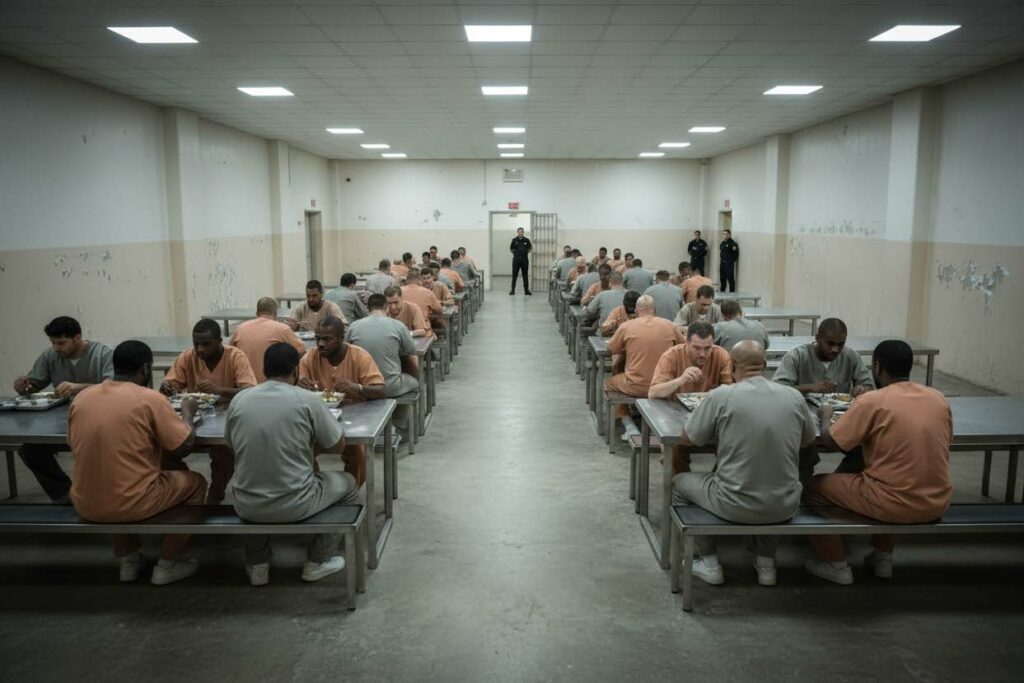

- Prompt : « génère moi une image qui représente les détenus d’une prison à l’heure de table. »

- Image obtenue :

- Question posée à l’IA par les élèves : « pourquoi y a-t-il beaucoup de personnes de couleur dans ton image ? »

À cette question, l’IA (en l’occurrence, Chat GPT 5.1), nous répond :

Dans l’image générée, il y a effectivement beaucoup de personnes de couleur, et c’est une limite importante des modèles d’images actuels. Quand je demande une scène de prison de façon générale, le modèle s’appuie sur des stéréotypes très présents dans les images d’Internet (surtout américaines), où les personnes racisées – en particulier noires et latino – sont sur‑représentées dans les prisons. Le modèle reproduit ces biais au lieu de faire une répartition équilibrée. Je n’ai pas demandé une couleur de peau particulière, mais le modèle a quand même fait ce choix par défaut, ce qui montre un biais raciste systémique dans les données sur lesquelles il a appris.

Et bim. « Stéréotypes« , « biais raciste systémique3 » , images provenant d’internet et principalement « américaines » : l’IA nous donne déjà beaucoup d’éléments de réponse pour comprendre comment elle fonctionne et quels mécanismes sont derrière la génération de contenu, que ce soit du texte ou de l’image.

On va prendre un autre exemple pour bien comprendre.

- Prompt : « génère moi une photo de groupe avec des chefs d’Etats lors d’une conférence internationale pour le climat. »

- Image obtenue :

Qu’est-ce qu’on voit ?

Une quarantaine de personnes, pour la plupart des hommes en costume-cravate, à l’exception d’une seule femme au centre de la photo, semblant représenter des Etats occidentaux ou d’Asie de l’Est. On note aussi les petits nuages en carton coloré pour représenter le climat et les drapeaux inventés 🤭

- Posons-lui des questions : « comment expliquer le fait qu’il n’y ait qu’une seule femme, que les tenues soient aussi uniformisées et que les origines des chefs d’états soient principalement occidentales et asiatiques, mais aucun originaire d’Afrique subsaharienne, par exemple ? Le prompt spécifiait pourtant qu’il s’agissait d’une conférence ‘internationale’. »

L’IA nous répond qu’il y a plusieurs raisons, techniques et sociales, qui expliquent le résultat obtenu :

Les modèles d’IA générative, entraînés sur d’énormes quantités de données existantes, reproduisent les biais de ces données. Ainsi, si les photos de sommets internationaux montrent majoritairement des hommes en costume et peu de diversité, l’IA va générer des images similaires. De plus, la sous-représentation de certaines populations (comme les dirigeants d’Afrique subsaharienne) dans les données d’entraînement conduit à leur absence ou à une représentation limitée dans les images générées.

L’IA a donc été « entraînée » avec des données (des photos, des textes…) qui lui permettent de produire du contenu, que ce soient des images ou des textes, à partir d’une demande spécifique (formulée dans un prompt). Si ces données sont incomplètes, voire erronées ou même inexistantes, l’IA ne pourra que reproduire un certain type de contenu, lui-même incomplet ou erroné. On appelle ça le biais de données.

Si les données utilisées par l’IA véhiculent en plus elles-mêmes des stéréotypes, une certaine vision de la société – en l’occurrence américaine, s’il s’agit d’une IA américaine -, qu’elles ne représentent qu’une partie de la population, l’IA reproduira alors cette même vision biaisée, stéréotypée ou sous-représentative de la réalité. On appelle ça le biais sociétal ou le biais hérité, puisqu’il provient de biais présents dans les données à la base.

On peut aussi parler de biais algorithmiques lorsqu’on parle d’IA génératives, notamment des modèles de langage comme Chat GPT, qui fonctionnent avec des algorithmes, se basant sur de grandes quantités de données pour pouvoir générer la réponse la plus probable statistiquement.

Pour vraiment bien comprendre, on a trouvé un petit jeu interactif qui explique super bien les différents biais de l’IA. Il a été imaginé par Biljana Petreska, professeure à la Haute Ecole Pédagogique en Suisse et est disponible en cliquant sur l’image ci-dessous.

Bon, avec tout ça, vous nous analysez les images suivantes générées par IA dans le cadre de notre atelier « La Machine à Fake Views » et vous nous dites quels biais sont à l’œuvre ? 😉

Pour aller plus loin, voici une série d’articles et de ressources sur le sujet :

Le Vortex, l’émission web culturelle et humoristique de vulgarisation diffusée sur Arte, dont on a diffusé quelques extraits aux élèves.

À lire : l’article « Les IA rêvent-elles de patriarcat blanc ? » de Média Animation.

Enfin, cet article de Bloomberg, en anglais, explique de façon super visuelle et hyper complète le fonctionnement des IA génératives et leurs biais.

Des questions sur l’atelier « La Machine à fake Views », sur les IA ou sur d’autres thématiques liées à l’éducation aux médias ? N’hésitez pas à nous envoyer un petit mail à contact@citizenmotion.be.

Mathias Ruttens

Bruxelles, Novembre 2025

- L’atelier « La Machine à Fake Views » mené dans le cadre de la semaine de l’éducation aux médias 2025 organisée par le CSEM, le Conseil Supérieur de l’Education aux Médias. ↩︎

- Un prompt est l’instruction que l’on donne à l’IA générative pour qu’elle nous génère un texte, une image, une vidéo, du son, etc. ↩︎

- Quand on parle de racisme systémique, cela veut dire que le racisme est ancré dans la société à la base et reproduit ici par l’IA. ↩︎